→ popblue: 何不先用AWS測試你需要什麼硬體規格再來 42.73.68.247 06/16 16:05

→ popblue: 買? 42.73.68.247 06/16 16:05

→ moonlightz: 用mac會不會比較好? 42.79.227.235 06/16 16:07

推 greg7575: 4090 屌打各式CPU 1.169.218.12 06/16 16:14

推 vieris: 用cpu跑太慢了 用gpu的話沒有40g以上的ram 109.42.179.180 06/16 16:30

→ vieris: 根本塞不進LLM 有自己訓練的需求不如去租s 109.42.179.180 06/16 16:30

→ vieris: erver來用 109.42.179.180 06/16 16:30

→ scarbywind: 去對岸挖過時的EPYC比較有機會吧 114.46.146.58 06/16 16:31

→ scarbywind: 如果你有辦法用cpu去跑的話 114.46.146.58 06/16 16:35

→ scarbywind: 24通道 40萬台幣 114.46.146.58 06/16 16:36

→ scarbywind: 不過這好像跟過時沒關係(X) 114.46.146.58 06/16 16:37

→ spfy: 所以你還沒測過CPU跑的效果? 27.52.65.195 06/16 16:42

推 ptta: colab pro, AWS都可以先測試一下? 220.136.10.210 06/16 16:47

→ ptta: 花個幾百塊台幣而已 220.136.10.210 06/16 16:47

→ kivan00: 先試看看花多少時間建立環境跟調整 用用 122.118.53.96 06/16 17:12

→ kivan00: 看囉 Nvidia猛的是在生態 122.118.53.96 06/16 17:12

→ yymeow: 我自己跑GPT的心得是,瓶頸在GPU 114.37.2.212 06/16 17:32

推 AIRURU: 可以考慮用vast租2-4張4090跑跑看感受下效 59.126.120.156 06/16 17:33

→ AIRURU: 果 59.126.120.156 06/16 17:33

→ yymeow: 然後還跟VRAM有關係,VRAM不夠,給的文章 114.37.2.212 06/16 17:33

→ yymeow: 長一點,就讀不下去了 114.37.2.212 06/16 17:34

推 AIRURU: 我的意思是先用租的確認模型執行需要的vra 59.126.120.156 06/16 17:55

→ AIRURU: m,例如先跑q4評估精度、速度可不可用上下 59.126.120.156 06/16 17:55

→ AIRURU: 文要多長,如果tps很夠用可以再考慮是否降 59.126.120.156 06/16 17:55

→ AIRURU: 級改更多卡湊vram 59.126.120.156 06/16 17:55

→ narukaza: 這預算怎麼會是選INTEL,連垃圾佬都不 114.34.174.204 06/16 18:23

→ narukaza: 撿的東西(X 114.34.174.204 06/16 18:23

→ narukaza: EPYC 7002 7003對岸撿不是隨便都比W5-3 114.34.174.204 06/16 18:23

→ narukaza: 435好嗎,你看我剛撿的7K62單顆都吊打3 114.34.174.204 06/16 18:23

→ narukaza: 435...你這預算都可以組雙路了吧 114.34.174.204 06/16 18:23

推 FXW11314: 不是,你都已經研究到知道這玩意兒很吃 42.73.135.226 06/16 18:31

→ FXW11314: memory bandwidth 了怎麼還會想用CPU跑 42.73.135.226 06/16 18:31

→ FXW11314: ?DDR跟GDDR是可以差一個數量級的欸 42.73.135.226 06/16 18:31

推 Ghosts: 3090x4 + nvlink(非必要) 最簡單 140.118.155.56 06/16 18:35

→ Ghosts: 價格也不會到無法負擔,只是二手風險高 140.118.155.56 06/16 18:35

→ Ghosts: llama.cpp的問題是高併發會輸vllm 140.118.155.56 06/16 18:35

→ Ghosts: 除非要用cpu+gguf 4bit之類的模型 140.118.155.56 06/16 18:35

→ Ghosts: 不然個人偏好還是vllm+gpu 140.118.155.56 06/16 18:35

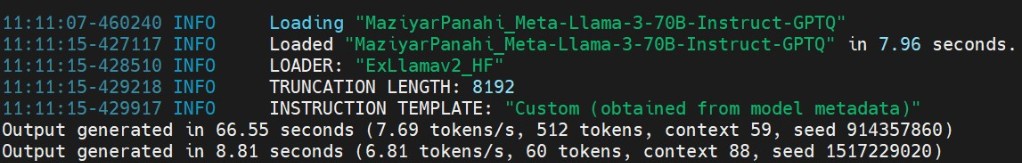

→ Ghosts: 然後12t/s超慢,顯卡隨便都能破百以上 140.118.155.56 06/16 18:37

推 FXW11314: 再說即使只跑推理本質上還是一堆矩陣運 42.73.135.226 06/16 18:40

→ FXW11314: 算,GPU還是比CPU有優勢 42.73.135.226 06/16 18:40

噓 jeffguoft: 這排版沒人噓? 49.159.249.60 06/16 18:44

→ sachialanlus: 感謝大家的建議,真的看到好多之前 118.160.35.51 06/16 18:55

→ sachialanlus: 沒有注意的盲點。我想我應該會先試 118.160.35.51 06/16 18:55

→ sachialanlus: 試看租高階 CPU 和多卡的機器來比較 118.160.35.51 06/16 18:56

→ sachialanlus: 看看,如果效能差異很明顯的話就直 118.160.35.51 06/16 18:56

→ sachialanlus: 接買多卡來組了。感謝大家~ 118.160.35.51 06/16 18:56

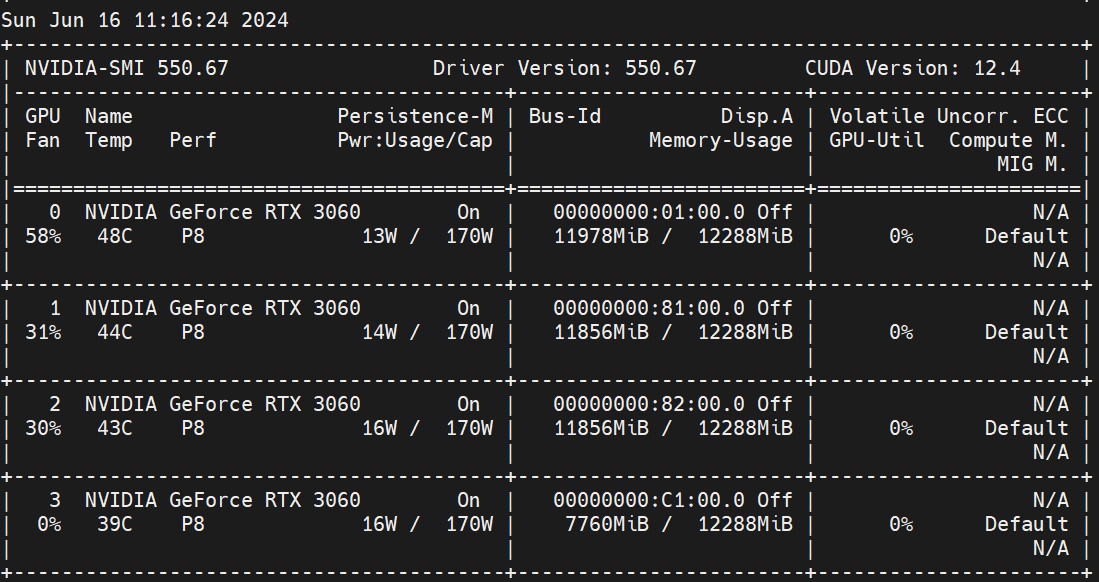

推 AIRURU: 用最丐的3060測試堆vram也比cpu快多了,70 59.126.120.156 06/16 19:35

→ AIRURU: B-Q4 59.126.120.156 06/16 19:35

→ AIRURU: 預算夠就直上兩張4090比較實在 59.126.120.156 06/16 19:35

推 aegis43210: 推論要用支援AMX指令集的CPU 223.137.30.114 06/16 20:49

推 aegis43210: 不然就要模型有支援老黃的推論單元 223.137.30.114 06/16 20:54

→ aegis43210: EPYC又不支援AMX,最差選擇 223.137.30.114 06/16 20:55

推 jeff85898: 除非是對資料隱私有需求 不然自己架LLM 111.253.44.161 06/16 21:16

→ jeff85898: 做推論 電腦和冷氣電費、噪音加一加成 111.253.44.161 06/16 21:16

→ jeff85898: 本太高了 111.253.44.161 06/16 21:16

推 jeff85898: 啊如果真的要入坑就對岸撿一組EPYC組多 111.253.44.161 06/16 21:27

→ jeff85898: 卡 或是用ARM Mac跑也許會比較安靜省電 111.253.44.161 06/16 21:27

→ nemo33: AWS EC2 G5/G6 跑 inference 118.169.226.32 06/16 21:49

推 ClixTW: 我跑Commamd R,記憶體沒爆還是慢到無法 101.136.14.4 06/16 22:41

→ ClixTW: 接受(大概每秒1Token),處理器也跑不滿 101.136.14.4 06/16 22:41

→ ClixTW: ,還是給VRAM跑吧 101.136.14.4 06/16 22:41

推 shiauber: 要塞70b的 就建議直上租借了... 1.161.209.244 06/16 23:26

→ shiauber: 70b 也只是入門 1.161.209.244 06/16 23:26

→ shiauber: 剛剛看到老黃推出了 340b 1.161.209.244 06/16 23:26

→ shiauber: 稍微看了一下 要inference 1.161.209.244 06/16 23:26

→ shiauber: 至少兩張 A100 or 一張 h100 1.161.209.244 06/16 23:26

→ shiauber: 這段演化真的衝很快,還是是老黃說了算 1.161.209.244 06/16 23:30

→ shiauber: 總之多學多看 實作真的可以省一點 1.161.209.244 06/16 23:30

→ shiauber: 論文現在是天天噴發 llama2才發布多久 1.161.209.244 06/16 23:30

→ shiauber: llama3就出來 迭代太快了 1.161.209.244 06/16 23:30

→ DLHZ: 你這完全沒研究的不如先去租個容器來用看看 111.71.213.112 06/17 00:04

→ DLHZ: 再說 111.71.213.112 06/17 00:04

推 jyhfang: 有個麻煩的地方 現在這些模型和硬體超級 220.134.41.251 06/17 05:04

→ jyhfang: 快 自己買硬體弄這些 會不會很快就跟不上 220.134.41.251 06/17 05:05

→ jyhfang: 更好的模型的基本需求? 更高效率的硬體 220.134.41.251 06/17 05:05

→ jyhfang: 或是 更棒的模型但基本需求也快速提升 220.134.41.251 06/17 05:06

→ jyhfang: 之類的 這跟現在一般自組電腦對應的需求 220.134.41.251 06/17 05:07

→ jyhfang: 完全不同 220.134.41.251 06/17 05:07

推 ChouEita: 建議你好好研究模型Inference 是用什麼 101.12.19.127 06/17 09:06

推 RoarLiao: 現在噴發期除發為了賺錢不然真的不建議 61.216.44.21 06/17 11:08

→ RoarLiao: 為了興趣砸大錢 61.216.44.21 06/17 11:08

推 RoarLiao: 然後所有人都在搞gpu的項目為什麼要自己 61.216.44.21 06/17 11:10

→ RoarLiao: 想繞過去用cpu搞自己.... 61.216.44.21 06/17 11:11